持续集成(CI)作业可以产生大量的数据。当作业失败时,找出了什么问题可能是一个繁琐的过程,需要对日志进行调查以发现根本原因-这通常是在作业总输出的一小部分中发现的。为了更容易地将最相关的数据从其他数据中分离出来,日志还原机器学习模型使用以前成功的作业运行来训练,以从失败的运行日志中提取异常。

此原则也可应用于其他用例,例如,从期刊或其他系统范围的常规日志文件。

利用机器学习降低噪声

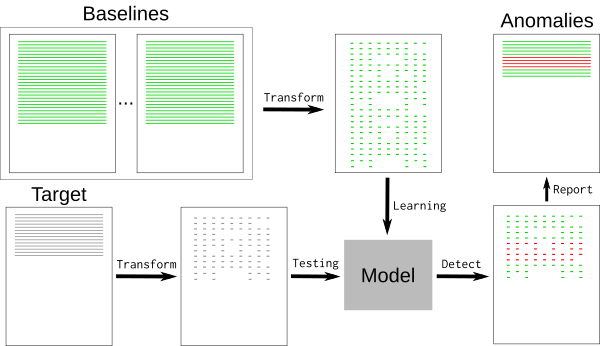

一个典型的日志文件包含许多名义事件(“基线”)以及一些与开发人员相关的异常。基线可能包含难以检测和删除的随机元素,如时间戳或唯一标识符。要删除基线事件,我们可以使用k最近邻模式识别算法 (k-NN)。

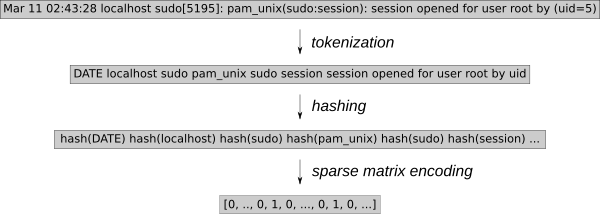

的日志事件必须转换为数值。k-NN回归。使用通用特征提取工具HashingVectorizer允许将该进程应用于任何类型的日志。它对每个单词进行散列,并在稀疏矩阵中对每个事件进行编码。为了进一步减少搜索空间,令牌化将删除已知的随机单词,例如日期或IP地址。

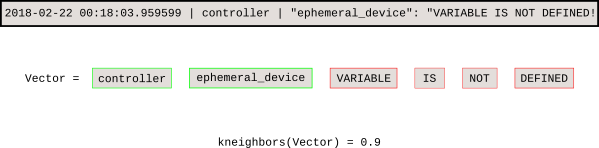

一旦模型被训练,k-NN搜索告诉我们每个新事件与基线之间的距离。

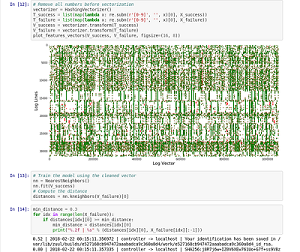

Jupyter notebook演示了稀疏矩阵向量的过程,并绘制了稀疏矩阵向量图。

介绍LOGPREIN

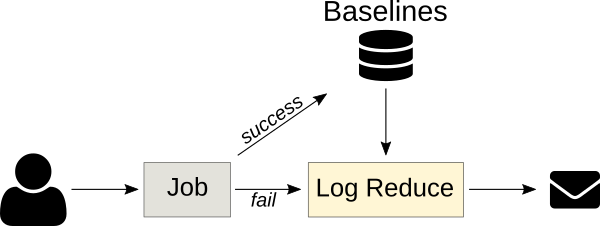

LogReallyPython软件透明地实现了这个过程。的最初目标是协助祖尔CI使用构建数据库进行作业失败分析,现在将其集成到软件厂发展锻造的工作日志过程。

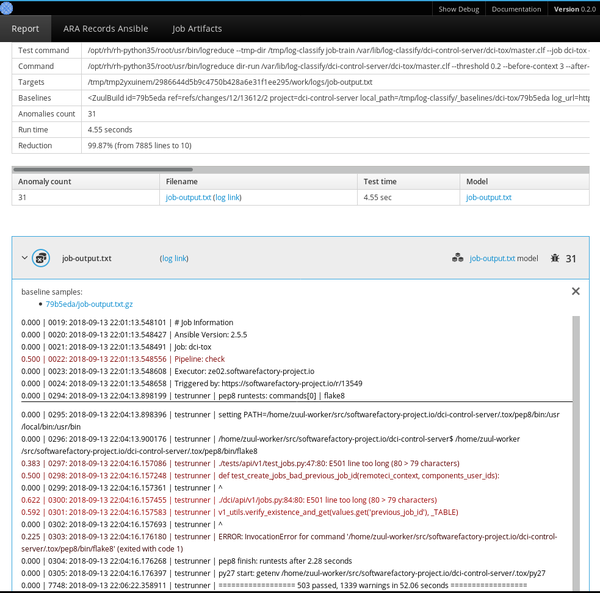

最简单的是,LogReduce比较文件或目录,并删除类似的行。Log冷水为每个源文件构建一个模型,并使用以下语法输出距离超过定义阈值的任何目标行:距离文件名:行号:行内容.

更高级的LogReduce使用可以将模型离线训练成可重用的模型。基线的许多变体可以用来适应k-NN搜索树

LogReduce还实现了接口,以发现日志时间范围(天/周/月)和Zuul CI作业构建历史记录的基线。它还可以生成HTML报告,在一个简单的接口中发现多个文件中的组异常。

管理基线

使用的关键k-神经网络回归异常检测是有一个已知的良好基线的数据库,该模型用于检测偏离过远的线。该方法依赖于包含所有标称事件的基线,因为基线中没有发现的任何事件都将被报告为异常。

Ci工作是我们的主要目标。k-NN回归,因为作业输出通常是确定性的,以前的运行可以自动用作基线。Log还原功能可以将Zuul作业角色用作失败的作业发布任务的一部分,以便发布简明的报告(而不是完整的作业日志)。这一原则可适用于其他情况,只要可以事先建立基线。例如,一个标称系统的SOS报告可用于查找有缺陷的部署中的问题。

异常分类服务

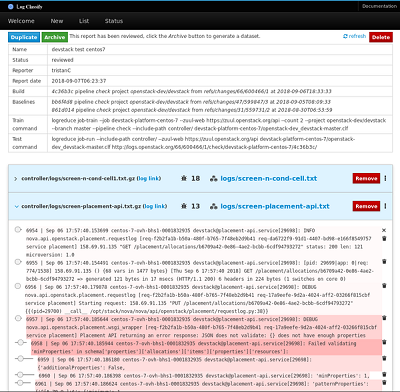

下一个版本的Logreduce引入了一种服务器模式,用于将日志处理卸载到外部服务,在该服务中可以进一步分析报表。它还支持导入现有的报告和请求来分析Zuul构建。服务运行异步地进行分析,并提供一个Web界面来调整分数和删除假阳性。

评审报告可以作为独立的数据集存档,目标日志文件和记录在平面JSON文件中的异常行的分数。

项目路线图

LogReduce已经被有效地使用了,但是有很多改进工具的机会。今后的计划包括:

总结

以上就是这篇文章的全部内容了,希望本文的内容对大家的学习或者工作具有一定的参考学习价值,谢谢大家对VEVB武林网的支持。

新闻热点

疑难解答